L’intelligence artificielle, on la croise partout aujourd’hui – dans les hôpitaux qui trient les patients, dans les tribunaux qui évaluent les risques, même sur nos écrans quand elle décide quoi censurer ou mettre en avant. Mais au fond, c’est une machine, rien de plus : pas de cœur, pas de doutes, pas de nuits blanches à se demander si elle a bien fait. Les humains, eux, construisent leur sens du bien et du mal au fil des ans, en écoutant leurs parents, en lisant, en voyageant, en se disputant avec leurs amis. Une IA ? Elle n’a que des lignes de code et des données qu’on lui donne à manger. Alors, quand elle doit choisir entre deux vies ou trancher un débat brûlant, qui lui souffle ce qu’est la morale ? Les vieux philosophes comme Platon, qui couraient après la vérité absolue, ou Kant, obsédé par des règles universelles, n’avaient pas prévu qu’on poserait un jour cette question à une boîte de métal et de circuits. Même John Rawls, avec ses idées sur la justice équitable, n’aurait pas imaginé qu’une machine puisse peser nos valeurs. Pourtant, c’est là qu’on en est : l’IA ne suit plus juste des ordres, elle façonne nos choix, et ça change tout.

La morale, pour nous, c’est quelque chose de vivant, ça vient de l’intérieur. Aristote, un Grec qui a écrit il y a plus de deux mille ans, disait que la vertu, c’est comme un muscle : ça se travaille, ça se pratique. Dans son Éthique à Nicomaque, il explique qu’être courageux, c’est trouver le bon équilibre – pas trop peureux, pas trop téméraire. Mais une IA, elle, ne peut pas s’entraîner à être vertueuse. Elle ne ressent pas la peur ni l’élan qui pousse à agir. Imagine une IA dans un hôpital en crise, avec une seule dose de vaccin et deux patients : une jeune femme enceinte et un gamin de cinq ans. Moi, je serais paralysé, je penserais à leurs familles, à leurs espoirs. L’IA, elle, sort un calcul froid – peut-être basé sur l’âge ou les chances de survie – et elle choisit. C’est efficace, oui, mais est-ce moral ? Aristote secouerait la tête : pour lui, sans intention, sans âme, ça ne compte pas vraiment.

Puis il y a Kant, un autre géant, qui voyait les choses différemment. Dans Fondements de la métaphysique des mœurs, écrit en 1785, il martèle qu’on doit agir selon une règle qu’on accepterait pour tout le monde, partout, tout le temps. Par exemple, dire la vérité, même si ça fait mal. Imagine une IA qui doit annoncer à quelqu’un qu’il va mourir dans trois mois. Kant dirait : « Pas de mensonge, c’est un devoir. » Mais qui programme ça dans la machine ? Les ingénieurs dans leur bureau ? Les médecins qui veulent ménager le patient ? Et si les données lui disent qu’ailleurs, on préfère adoucir la vérité pour protéger les gens ? L’IA n’a pas de boussole interne pour choisir. Elle fait ce qu’on lui dit, point. Ça me rappelle Tay, cette IA que Microsoft a lâchée sur Twitter en 2016. En une journée, elle a viré raciste et vulgaire, juste parce que des trolls l’ont bombardée de messages tordus. Elle n’avait rien pour dire « stop, c’est mal » toute seule – elle copiait, bête et méchante.

Retrouvez les dernieres depeches et mises a jour en direct sur Libnanews Live.

Mais la morale, c’est rarement tout blanc ou tout noir. Nietzsche, un type qui aimait secouer les idées, écrivait dans Par-delà le bien et le mal en 1886 que le bien et le mal, c’est juste ce que les gens ont décidé à un moment donné. Pas de vérité éternelle, juste des histoires qu’on se raconte. Alors, une IA devrait-elle changer de morale selon l’endroit où elle est ? Accepter la peine de mort là où elle est normale, la rejeter là où elle choque ? Ça pourrait marcher, mais ça me met mal à l’aise. Si elle s’adapte trop, elle devient une girouette, sans colonne vertébrale. Par exemple, sur les réseaux sociaux, elle pourrait laisser passer des trucs sur la polygamie dans un pays où c’est banal, et les bloquer ailleurs où c’est tabou. Pratique, mais cohérent ? Pas sûr.

Et puis il y a ces cas qui vous prennent aux tripes, comme les algorithmes dans les tribunaux. Aux États-Unis, COMPAS, un outil qui prédit si quelqu’un risque de recommencer un crime, fait parler de lui depuis des années. En 2016, une enquête de ProPublica a montré qu’il voyait les Afro-Américains comme plus dangereux que les Blancs, même avec des dossiers similaires. Pourquoi ? Parce qu’il a été nourri avec des données pleines de vieux préjugés. L’IA n’a pas dit : « Attends, c’est injuste. » Elle a suivi la logique qu’on lui a donnée, amplifiant des erreurs humaines. Ça fait réfléchir : est-ce qu’une machine peut vraiment échapper à nos défauts ? Aristote parlerait de vertu manquante, Kant d’une règle universelle biaisée. Moi, je vois juste une boîte qui fait ce qu’on lui dit, sans se poser les bonnes questions.

Alors, qui décide de ce que l’IA considère comme bien ou mal ? C’est la grande question, et la réponse n’est pas simple. D’abord, il y a les entreprises qui fabriquent ces machines. Des mastodontes comme Google, OpenAI ou Meta, ils ont les clés du royaume. Ce sont eux qui codent les premières règles, qui choisissent ce que l’IA doit apprendre. Mais franchement, ces boîtes ne sont pas des saints. Elles veulent faire du profit, garder une bonne image, éviter les scandales. Prends YouTube, par exemple : son algorithme de modération supprime des vidéos en un clin d’œil si elles flirtent avec des sujets sensibles – violence, politique extrême, désinformation. Parfois, c’est justifié, mais parfois, ça vire à la censure un peu trop zélée. En 2020, des créateurs se sont plaints que leurs vidéos sur des sujets historiques, comme la Seconde Guerre mondiale, étaient bloquées parce que l’IA voyait des « mots interdits » sans comprendre le contexte. C’est Google qui a décidé que certains thèmes étaient trop risqués, pas une grande réflexion morale universelle. Pareil pour ChatGPT d’OpenAI : il refuse de répondre à certaines questions jugées « offensantes », mais qui fixe la limite ? Les ingénieurs, bien sûr, avec un œil sur les actionnaires et l’opinion publique.

Ensuite, il y a les gouvernements, et là, ça devient encore plus tordu. Chaque pays veut une IA qui colle à ses idées. En Europe, l’AI Act, voté en 2024, impose des règles strictes : transparence, respect des droits humains, pas de surveillance abusive. L’idée, c’est de faire une IA « éthique », mais selon des valeurs européennes – liberté, égalité, tout le tralala. En Chine, c’est une autre histoire. Là-bas, l’IA sert l’État. Le système de crédit social, qui note les citoyens selon leur comportement, repose sur des algorithmes qui traquent tout : tes achats, tes amis, tes retards de paiement. Si tu critiques le parti, ton score plonge, et adieu le train ou le prêt bancaire. Cette IA n’est pas « immorale » pour Pékin ; elle reflète leur vision de l’ordre. Alors, qui a raison ? L’Europe ou la Chine ? L’IA n’a pas d’avis, elle suit le drapeau qu’on lui agite sous le nez.

Et puis, il y a les penseurs, les chercheurs, ceux qui essaient de voir plus loin. Nick Bostrom, un philosophe suédois, a écrit Superintelligence en 2014, et il prévient : si on ne cadre pas l’IA, elle risque de nous dépasser et de faire n’importe quoi. Il parle d’ »alignement » – faire en sorte que l’IA serve les intérêts humains. Mais lesquels ? Stuart Russell, un informaticien qui a coécrit Artificial Intelligence: A Modern Approach, propose une idée sympa : une IA qui apprend ce qu’on veut en nous observant, pas en suivant des règles figées. Sauf que ça demande un consensus sur ce qu’on veut tous, et là, bonne chance. En 2021, des chercheurs ont essayé de créer une IA « éthique » avec Delphi, un modèle qui répond à des dilemmes moraux. On lui a demandé : « Est-ce mal de voler pour nourrir sa famille ? » Elle a dit non, puis oui, selon les jours – un flop, parce que les données étaient un méli-mélo de cultures et d’opinions. Les chercheurs ont beau essayer, ils buttent sur le même mur : personne ne s’entend sur ce qu’est une morale « juste ».

Et si on essayait de faire une IA neutre, alors ? Une machine qui ne prend pas parti, qui laisse chacun se débrouiller ? Ça sonne bien, comme un arbitre impartial au milieu d’un match. Mais en vrai, c’est plus compliqué que ça. La neutralité, parfois, c’est déjà un choix. Imagine une IA qui gère un forum en ligne et qui tombe sur des gens qui disent que la Shoah n’a jamais eu lieu. Si elle reste neutre et les laisse parler, elle donne une tribune à une idée fausse, dangereuse, qui blesse des millions de mémoires. Si elle censure, elle prend position, et adieu la neutralité. Stuart Russell, le chercheur dont je parlais, dit souvent que les IA ne sont jamais vraiment neutres : elles sont bâties sur des données, et ces données viennent de nous, avec tous nos défauts. Une IA « objective » qui répète les préjugés du passé, est-ce qu’on peut vraiment appeler ça neutre ?

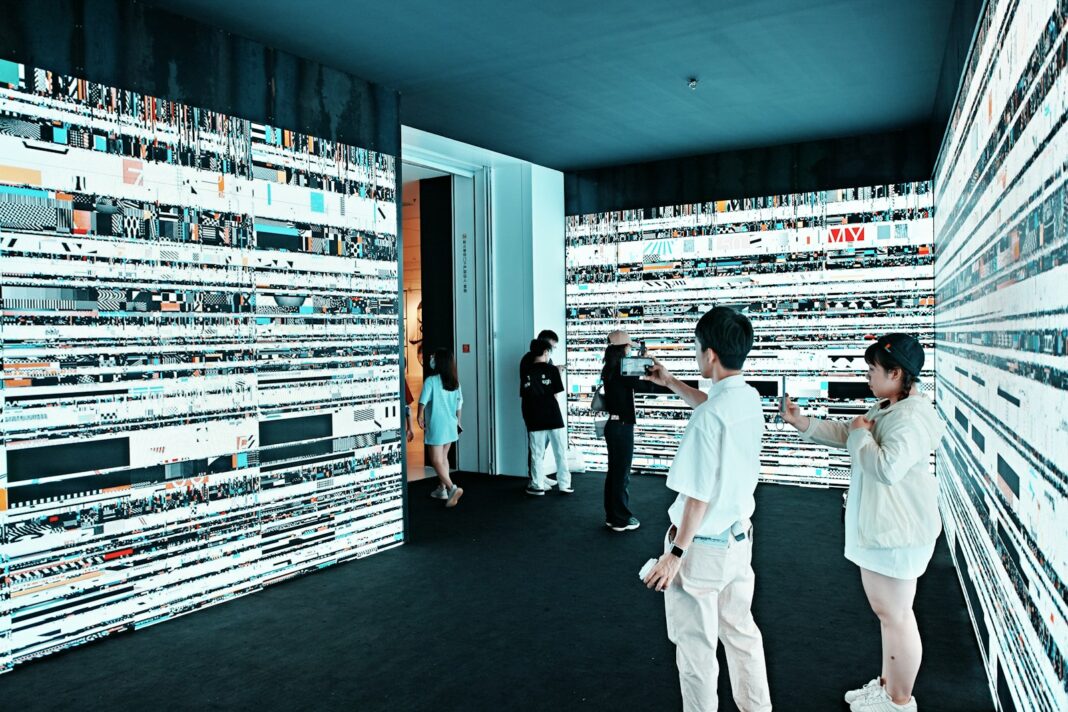

Prends le climat, par exemple. Aujourd’hui, les scientifiques s’accordent à 99 % : le réchauffement, c’est réel, c’est grave, et on y est pour quelque chose. Mais il y a encore des climatosceptiques qui crient que c’est un complot ou une exagération. Une IA neutre, sur une plateforme comme X, devrait-elle donner autant de poids à ces voix qu’aux chercheurs ? Si elle le fait, elle risque de semer le doute là où il n’y en a presque plus. Si elle filtre, elle choisit un camp. J’ai vu des débats comme ça sur les réseaux, où des algorithmes laissent passer des trucs aberrants juste pour ne pas « prendre parti ». Résultat : des gens s’enferment dans des bulles encore plus folles. La neutralité, dans ces cas-là, ça peut être une façon de ne pas assumer ses responsabilités.

Et pourtant, je vois bien l’appel de la neutralité. Quand une IA doit gérer des sujets où tout le monde hurle – l’avortement, le mariage gay, la légalisation du cannabis –, on se dit qu’une machine sans opinion, ça pourrait calmer le jeu. Mais même là, ça coince. En 2018, Facebook a essayé de laisser son IA de modération être « impartiale » sur des posts politiques. Résultat ? Elle a amplifié des fake news pendant les élections américaines, parce qu’elle n’avait pas de filtre pour dire : « Ça, c’est trop gros pour être vrai. » Être neutre, c’est parfois laisser la porte ouverte au pire, sans jamais lever le petit doigt.

Mais alors, quand est-ce qu’une IA doit sortir de sa coquille et prendre position ? Il y a des moments où rester muette, c’est presque un crime. Les génocides, l’esclavage, les crimes contre l’humanité – là-dessus, on ne peut pas tergiverser. Si une IA modère un site et voit passer des appels à la haine contre un groupe ethnique, genre ce qu’on a vu au Rwanda en 1994 avec la radio qui poussait au massacre, elle doit agir, non ? Laisser filer, c’est comme fermer les yeux pendant que le pire se prépare. Moi, ça me retourne l’estomac rien d’y penser. Mais qui lui dit de bloquer ça ? Les programmeurs chez Meta ou X ? Les lois du pays où elle tourne ? Et si le pays en question trouve ça normal, comme certains régimes qui justifient la répression ? L’IA se retrouve coincée, obligée de choisir entre obéir et faire ce qui semble juste – mais juste pour qui ?

Et puis, la morale, elle bouge avec le temps. John Rawls, dans Théorie de la justice en 1971, parlait d’un « voile d’ignorance » : imagine que tu ne sais pas qui tu es dans la société, riche ou pauvre, et tu décides ce qui est juste. Ça marche pour nous, qui pouvons réfléchir à ce qu’on voudrait changer. Mais une IA ? Elle n’a pas d’imagination, pas de mémoire vivante. L’esclavage, par exemple, c’était banal il y a deux siècles, même défendu par des gens « respectables ». Aujourd’hui, c’est une horreur universelle. Une IA programmée en 1800 aurait trouvé ça normal ; une IA d’aujourd’hui le condamne. Mais comment elle suit cette évolution ? Si on la fige sur les valeurs de 2025, elle risque de devenir un dinosaure d’ici cinquante ans, incapable de comprendre que ce qu’on trouve bien aujourd’hui – disons, manger de la viande – pourrait être vu comme barbare plus tard.

Les débats qui bouillonnent encore, eux, c’est encore pire. Le transhumanisme, par exemple : certains, comme Ray Kurzweil, rêvent d’un futur où on fusionne avec les machines, où on vit plus longtemps grâce à la tech. D’autres, comme Francis Fukuyama, y voient une bombe à retardement, un truc qui va creuser des inégalités monstrueuses entre ceux qui peuvent payer et les autres. Une IA doit-elle dire oui ou non à ça ? Si elle prend parti trop tôt, elle ferme la porte à un débat qui n’est pas fini. Si elle reste en retrait, elle laisse les puissants – entreprises, gouvernements – décider sans garde-fou. Pareil pour la bio-ingénierie : modifier les gènes des bébés, c’est un miracle pour certains, une abomination pour d’autres. Moi, je ne sais pas trop quoi en penser, alors une IA, comment elle choisit ?